두유의 디지털라이프

새로운 문이 열린 소니 A7R5의 AI AF 체험을 해보고나니 본문

오래간만에 소니 카메라와 관련된 오프라인 행사에 참석해보게 되었다. A7R5 이전에 마지막으로 참석해본 소니 카메라 관련 행사는 다음 링크에서.

https://dooyoou.tistory.com/56

소니 a9II 웨딩위크이벤트 촬영본을 직접만든 라이트룸 프리셋과 LUT으로 보정해봤습니다

저는 현재 웨딩 본식스냅 촬영용으로 소니 a7M3 두 대와 소니 24-70GM, 55.8za, 85GM을 사용하고 있습니다. 기타 초광각이 필요한 호텔예식 등에는 다른 렌즈를 사용하긴 하지만, 기본적으로는 소니 풀

dooyoou.tistory.com

이 당시에도 적층형 센서의 기술적 우위에 충격을 받았었는데... 적층형 센서가 탑재된건 아니지만 AI를 통한 AF를 전면에 내세운 카메라라니. 이렇게 큰 기술적 변혁이 있을 때는 일단 가서 만져보고 체험해봐야만 뒤처지지 않을 수 있다는 생각에 꼭 참석해보고 싶었다.

에이다라는 이름이 있다. 서부권, 특히 독일이나 영국쪽에서 많이 쓰이는 이름이기도 하고, 미 국방부에서 표준언어로 쓰인 프로그래밍 언어의 이름이기도 하고, 꽤 큰 시총을 가진 암호화폐의 이름이기도 하다. 그리고 이 프로그래밍 언어와 암호화폐의 이름은 세계 최초의 프로그래머로 인정받은 에이다 러브레이스의 이름에서 따왔다.

에이다 러브레이스는 그 유명한 영국의 시인 바이런의 딸이자, 무려 1800년대 초에 if문을 최초로 구현한 세계 최초의 프로그래머이기도 하다. 이 개념은 현재 거의 모든 프로그래밍 언어들이 사용하고 있다. 또한 에이다를 기리며 그녀의 이름을 딴 프로그래밍 언어인 ADA로 F-22의 항공 전자장비 소프트웨어를 만들기도 했다.

그렇게 1800년대 초에 에이다 러브레이스가 제어문 형태의 개념을 수립하고 알고리즘의 개념을 만들어낸지 200년만에 현 인류는 AI가 가사를 인식해서 해당 장면을 그림으로 그려주고, AI가 그린 그림이 대회에서 입선하기에 이르렀다. 첨단 기술과 어울리지 않을 것 만 같았던 아날로그적 분야에도 거의 모든 분야에 적용되고 있다.

그리고 카메라 AF에도 여지없이 AI가 적용되기 시작했다.

AF, 자동초점이라는 개념을 어떻게 정의해야하는지부터 고민해야할텐데, 그래야 AI가 도입되고 이것이 효과적이고 강력한지 이해할 수 있을 것이다. 기본적으로 카메라에서 AF라는 것은 뷰파인더 또는 화상 내에서 특정 지점의 거리검출 기능을 활성화시켜서 촬상면과 피사체까지의 거리를 검출하여 렌즈군을 돌려서 그 위치에 갖다놔주는 것을 의미한다. 기존의 카메라가 하는 역할은 DSLR을 기준으로 볼 때 뷰파인더 내의 측거점(으로 추정되는 위치) 의 위상차센서를 작동시켜서 거리를 측정하고, 그 측정값을 렌즈로 보내서 렌즈의 포커스렌즈 또는 렌즈군을 모터가 해당거리에 초점을 맞출 수 있는 위치까지 이동시키는 것이다.

구시대의 AF는 조이스틱을 쓰건, 방향키를 쓰건 간에 측거점을 옮겨서 초점을 맞추고자 하는 면의 위치를 사람이 지정해야 했다. 콘탁스 ND를 생각해보자. N1을 기반으로 했던 ND의 AF시스템은 중앙 1점과 상하좌우가 아닌 대각선 각 4점으로 황금분할에 가깝게 배치된 5점 중에서 사용자가 조이스틱을 대각으로 움직여가며 포인트를 골라서 반셔터를 누르면, 그때부터 카메라가 위에서 설명한 작동을 통해 초점을 맞춰주었다. 물론 그렇게 선택한 측거점에서의 AF 구동력과 정확도는 한숨만 나왔지만.

이 지점에서 추가적인 'AUTO' 의 개념이 들어갈 여지가 생긴다. 바로 사용자가 측거점을 옮기고 지정하는 과정이다. 아직도 내가 쓰고 있는 옆 동네의 중급형 마지막 DSLR을 비롯해서 최신의 DSLR에는 RGB센서가 들어가는데, 이 RGB센서가 렌즈를 통해 들어오는, 그리고 뷰파인더를 통해 볼 수 있는 시각의 RGB패턴을 분석해서 배경과 피사체를 분리해서 '판별' 하고 해당 피사체에 초점을 맞춰주는 기능을 구현함에 따라 전 측거점 오토 기능을 사용하게 된다(물론 옆동네 마지막 중급형 DSLR 세대때부터 시작된게 아니라 RGB센서가 들어간 DSLR부터이다). 참고로 동시기 저가형 DSLR의 RGB센서의 화소수는 8천화소가 채 안되는(8천만화소가 아니다, 8천화소다) 센서로 가로세로 각 100픽셀이 채 안된다. 내가 아직 사용중인 옆동네 마지막 중급형 DSLR의 RGB 센서는 약 15만화소니까 대략 480*320 쯤 되는 해상도의 RGB센서가 들어갔다고 추정할 수 있으며, 동세대 플래그십이었던 모델의 경우 약 36만화소, 대략 750*480 해상도의 RGB센서를 가지고 렌즈를 통과하는 빛을 분석했다.

결국 측거점을 사람이 수동으로 조이스틱 등의 도구를 조작해서 측거점을 선택하는 것이 아니라 'RGB분석을 통해 배경과 피사체를 분리한 다음에 화면 또는 뷰파인더 안에서 이 덩어리가 피사체이고 여기에 측거점을 옮겨서 AF를 구동시키겠다' 의 과정을 카메라가 자동으로 해줄 수 있고, 이 과정을 위상차 검출-렌즈 구동 과 분리해서 봐야한다는 이야기다. 그리고 AI는 바로 검출과 구동과정이 아닌 그 전 단계에서 도입된다.

기존 카메라들의 검출과 구동 전 단계인 분석을 담당하는 RGB센서의 분해능은 화소수를 보면 알겠지만 플래그십도 유튜브 480P 해상도 쯤 밖에 안되는거다. 4K 유튜브를 넘어서 8K 직캠이 넘쳐나는 시대에 이 분해능은 과장해서 말하면 최신 4090 그래픽카드 시대에 오락실 버츄어파이터 1의 깍두기 3D게임을 보는 것과 매한가지다(...)

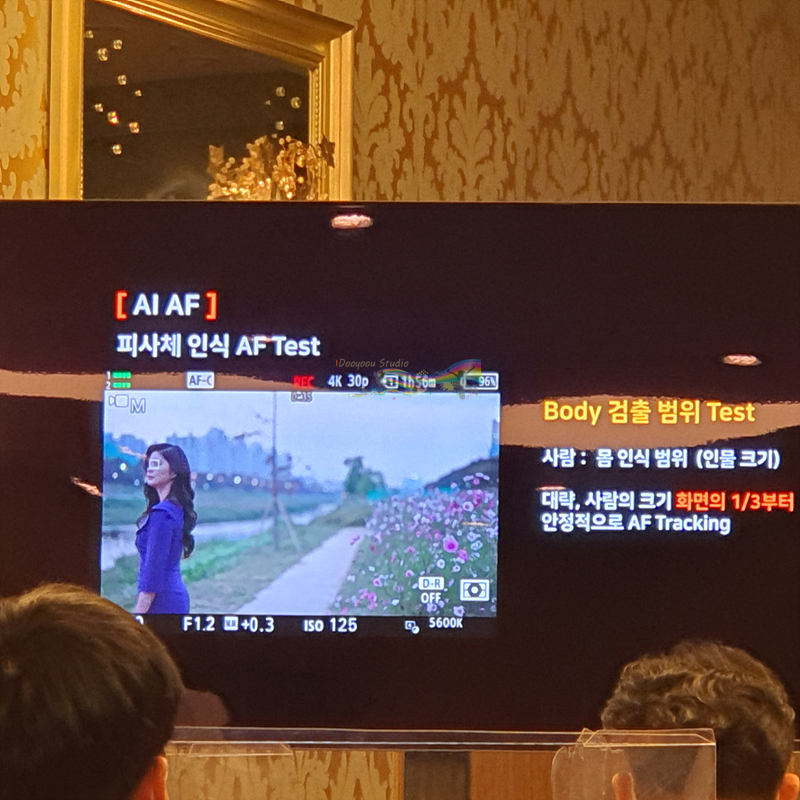

최신의 미러리스에서는 어떨까. DSLR과 달리 미러리스는 RGB센서를 추가로 넣어서 분석할 필요 없이, 렌즈를 통과한 빛이 바로 센서에 도달하기 때문에 센서에서 읽어들이는 화면의 RGB값을 바로 분석하면 그만이다. 물론 이 경우 센서의 화소수를 그대로 전부 사용하면 처리해야할 데이터의 양이 저화소의 RGB센서 분석에 비해 어마어마하게 폭증하기 때문에 전화소를 다 분석에 사용하진 않지만. 이렇게 높아진 분해능을 바탕으로 화면을 판독한 다음, 피사체가 사람인지 동물인지, 동물이라면 조류인지 포유류인지, 혹은 자동차나 비행기 같은 탈 것인지, 사람이라면 화면 내에 사람의 전신이 들어와있는지 아닌지, 몸의 방향은 어디를 향하고 있는지, 얼굴과 눈은 어디에 있고 마스크를 끼고있을 때 눈의 위치는 어디인지를 그냥 화면 내 컨트라스트분석이 아닌 AI 알고리즘이 추정하고 지정해내는 것이 바로 A7R5의 AI 프로세싱이다.

단순히 배경과 피사체를 분리하고 근거리의 대상을 지정해주는 것에 그치는 자동이 아니라 화면 내에 사람이 몇 명인지, 몸의 방향은 어느 방향으로 돌리고 있으며 그렇게 몸을 돌렸을 때 몸통은 어디에 위치해있는지까지 별도의 AI프로세싱유닛이 다 파악해준다는 말에 어디까지 가능한지 알고싶어서 A7R5의 신제품발표회에 참석을 신청하게 되었고, 감사하게도 체험해 볼 기회를 얻게 되었다.

저녁 8시에 시작이었는데 퇴근하고 근처에 가니 시간이 좀 뜨기도 하고 밥을 안준다고 해서, 밀본에서 고기덮밥을 먹었다. 양도 많고 맛도 좋고 좋았는데 후추만 좀 덜했으면...

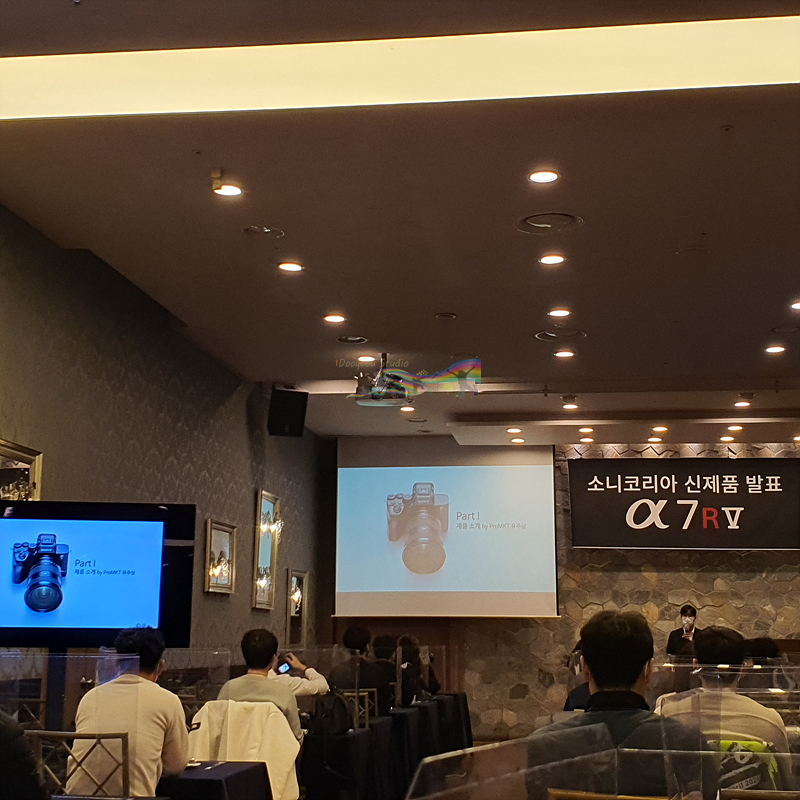

밥먹고 도착해서 자리에 앉으니 딱 시간이 맞아서 바로 시작한 세미나. 코땡땡 이후로 3년여만에 오프라인 행사를 가본 것 같다.

개인적으로 sf-e 메모리좀 싸게 대량으로 많이 풀었으면 좋겠다. 쓰기속도야 뭐 128기가 이상으로 올라가면 UHS-2 기준 적당적당한 수준으로 잘 올라오니깐. 적당한 가격에 128기가나 256기가 풀어주면 대량으로 사서 잘 써먹을 것 같은데 아직은 가격이 살짝은 아쉬운 수준. 조금만 더 숨 참아본다...

사은품으로 주신 메모리카드는 예비용으로 잘 사용하고 있다.

여담으로 이 공간은 웨딩 본식스냅이나 영상하는 사람들에게는 아벤티움이라는 이름으로 잘 알려진 브라운스톤 컨벤션이다. 당장 이 주 주말에 이 곳에서 촬영이 하나 있었기 때문에 좀 재미있었다(ㅎㅎㅎㅎ) 원래 이 곳은 피로연장으로 쓰이는 곳인데 이렇게 해두니까 또 신기.

구구절절 장황하게 썰을 풀었던 문제의 AI AF. 눈을 잡다가 피사체가 몸 방향을 돌리면 끝까지 눈을 잡고있다가 바로 머리->몸통으로 측거점의 크기와 모양이 변하면서 계속해서 잡아주는 모습이 매우 인상적이다. 이 날 시연장에서 양해를 구하고 모델이 서있는 곳 좌우를 계속 카메라들고 걸어다녔었는데 모델이 행사장 안에서 몸 방향을 돌리는 각도에는 한계가 있으니 내가 직접 좌우로 움직였던 건데, 바로바로 잡아내는게 놀라웠다. 지금와서 생각해보니 닌자 들고가서 화면 따올걸... 하는 생각이 바로 들었지만 퇴근하고나서 간 거라 피곤하다보니... .그 생각이 안들었었다.

볼때마다 갖고싶은 24-70 2. 가볍고 무게중심이 잘맞아서 좋다. 매번 이야기하는거지만, 바디와 렌즈의 무게중심이 잘 맞으면 마치 무협지에서 강도가 높고 무거워서 파괴력은 크지만 무게중심이 잘 맞아서 다루기 쉬운 대검을 휘두르는 것 같은 느낌을 받을 수 있다(...) 24-70 2 는 무협지의 그 묘사에 딱 부합한다.

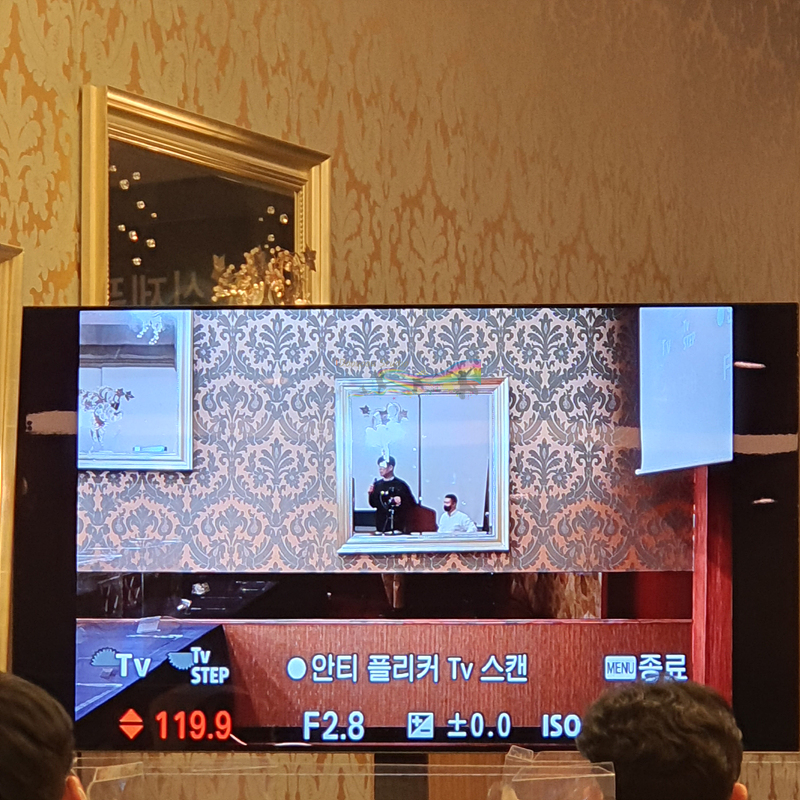

A9II에 들어갔던 셔터스피드를 주파수단위로 쪼개서 플리커를 줄이는 기술. 예전에는 하나하나 돌려가며 얼룩이 덜생기는 주파수를 찾아서 찍어야했다면 이제는 그 주파수를 카메라가 알아서 찾아준다. 뭐야 이거 무서워...

그리고 내 메모리카드를 넣고 찍어본 간단한 테스트샷. 기존의 프리셋도 여전히 잘 먹는다. 마음에 든다.

간단하게 리더스로직 v90 메모리카드를 넣고 테스트를 해봤는데 jpg 기준으로 기존에 만들어두었던 프리셋도 매우 잘 먹어들어가고, AI AF는 몸 방향이 카메라를 향해있던 아니건간에 정확하게 사람을 검출해내고, 6100만화소의 해상력과 고화소 블러를 막아줄 8축 손떨방의 조합은 매우 강력했다. 6100만화소쯤 되면 기존의 낮은 화소 카메라로 찍는 것보다 훨씬 더 고화소 블러에 조심해야 할텐데, 8축 손떨방의 위력 덕분인지 R3 쓸 때의 느낌으로 흔들렸을 것 같은 사진촬영 습관들이 6100만 화소의 A7R5에서 100% 확대해봐도 블러가 없어서 놀라웠다. 개인적으로 무손실압축로우 M 기준 2600만화소에 틸트랑 스위블이 동시에 되는 4축 멀티앵글 액정이 2470 하나 달아놓고 본식 스냅할 때 딱일 것 같고, 영상할 때 지금 메인으로 쓰고 있는 A7S3는 4K로 찍고 A7R5 는 8K로 찍은 다음에 확대편집에 여유를 둘 수 있게 구성하면 아주 좋을 것 같아서 지름의 기회만 보고 있다. 기존 프리셋도 큰 변화 없이 아주 잘 먹어서 워크플로우에 큰 변화는 없을 것 같아서 아주 마음에 든다.

'IT&Tech > Camera' 카테고리의 다른 글

| 유튜버용 카메라 소니 zv-1 예판플렉스~! 한 개봉기 (0) | 2020.06.12 |

|---|---|

| 나이트코어 USN4 Pro 소니 FZ100 듀얼충전기를 또(!) 샀습니다. (0) | 2020.06.02 |

| 삼각대거치가 되는 카메라용 하드케이스 맨프로토 프로라이트 리로더 H-55 (0) | 2020.03.10 |

| 유튜브를 위한 영상용 삼각대 맨프로토 비프리 라이브 (0) | 2020.03.10 |

| 직접 질러서 맞대본 니콘 z6와 소니 a7m3 크기 및 디자인 비교 (0) | 2020.01.31 |